Proxmox VEで作成したVMをVMware ESXiに移行する。

VMが停止状態であればそのままディスク形式をvmdkにしてやればよい。

qemu-img convert -O vmdk VMディスク.qcow2 VMディスク.vmdk

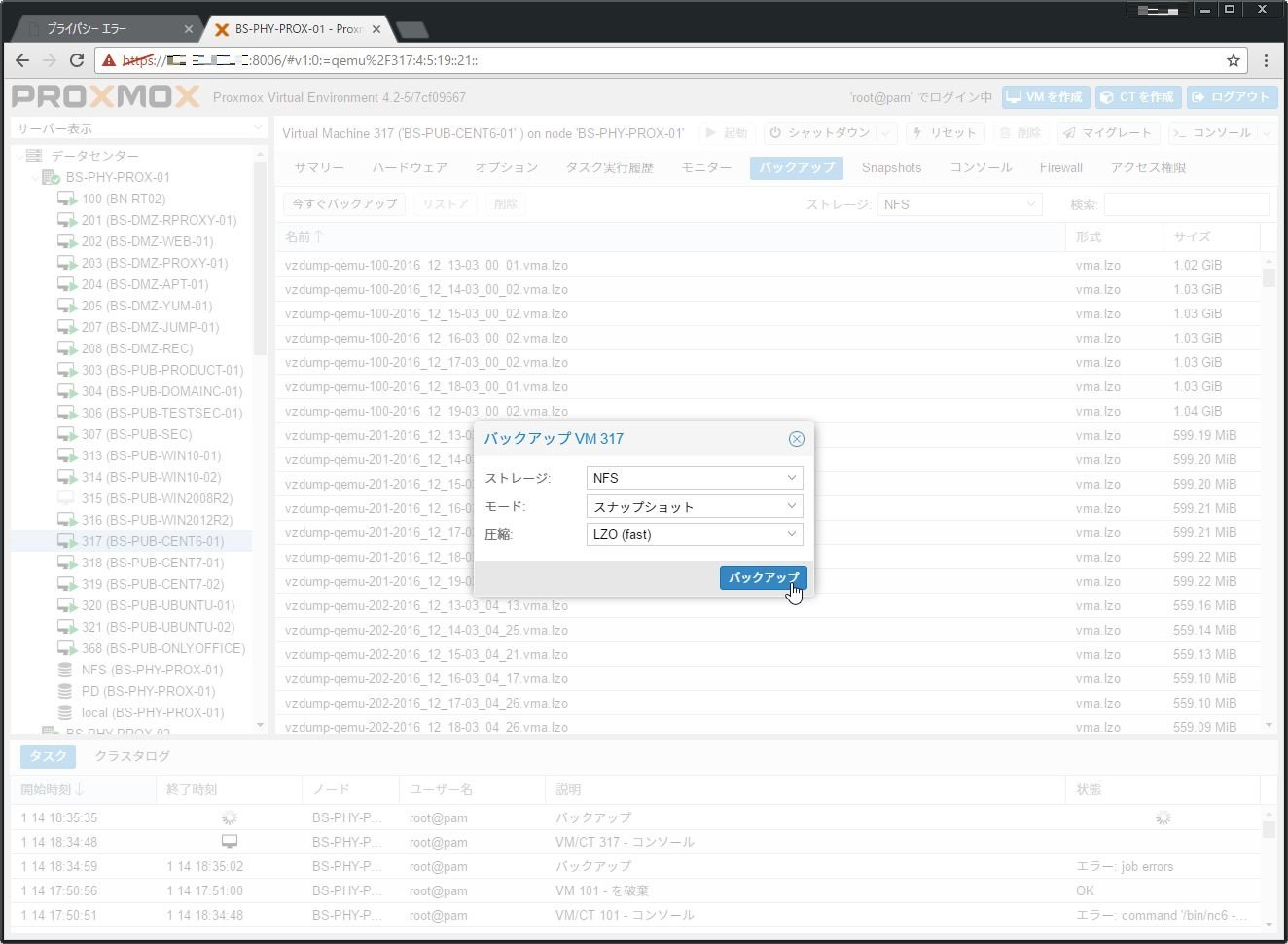

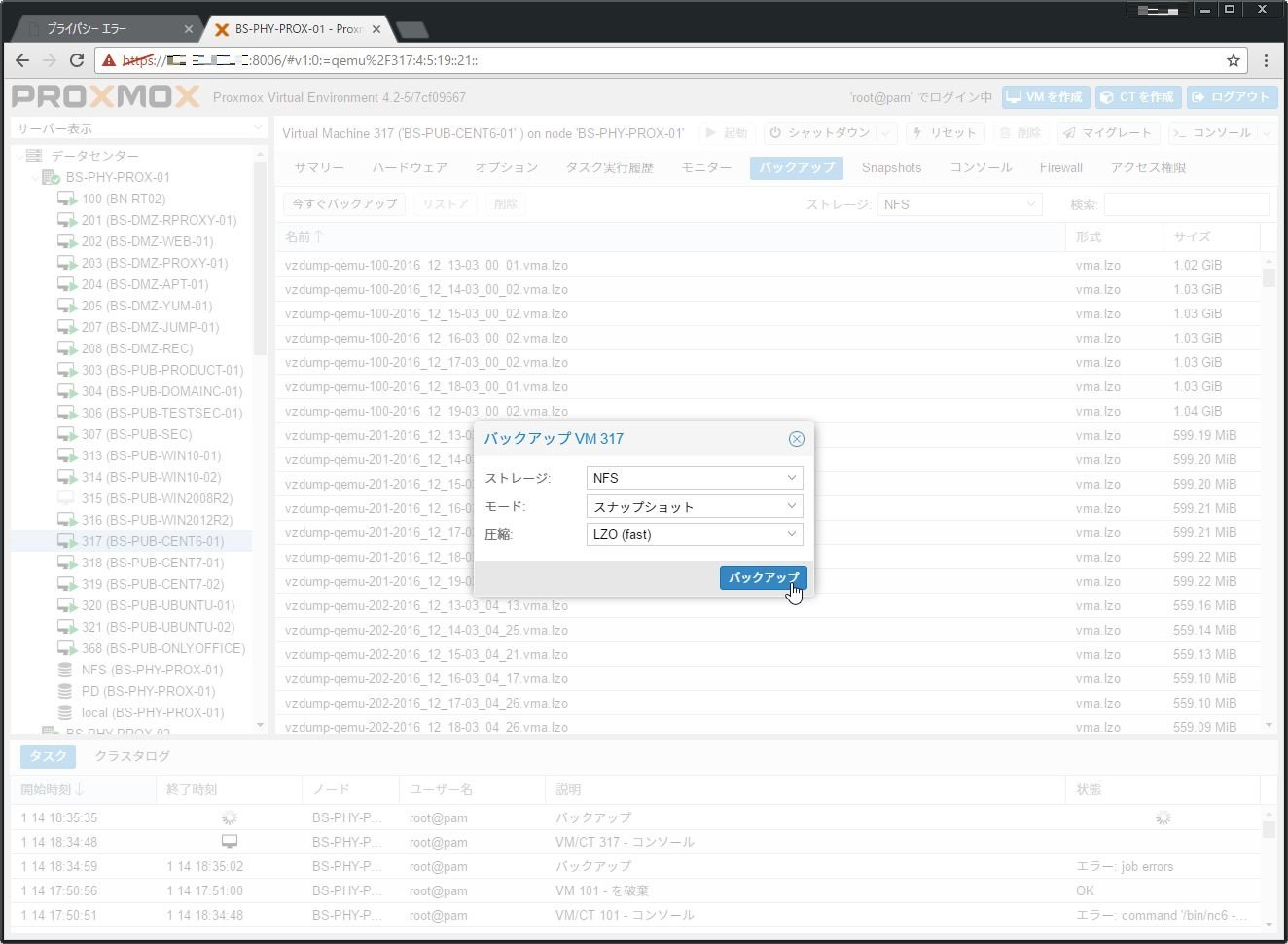

稼働中のVMを移行する場合は、まずProxmox側でVMのバックアップ取得を行う。

バックアップは、対象のVMを選択して[バックアップ]タブで行える。

バックアップファイルが取得できたら、ProxmoxVEにssh接続し、以下のコマンドを実行してバックアップファイルからVMware ESXi上で利用できる仮想ディスクを取得する。

...

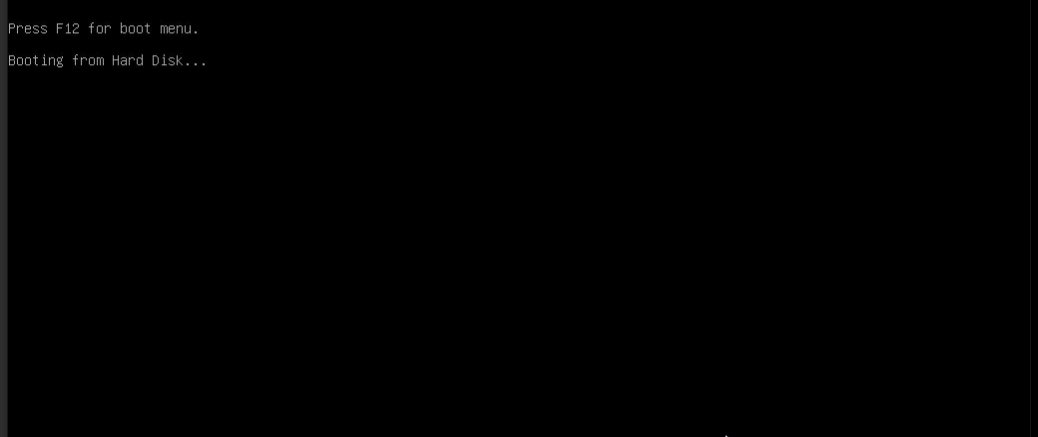

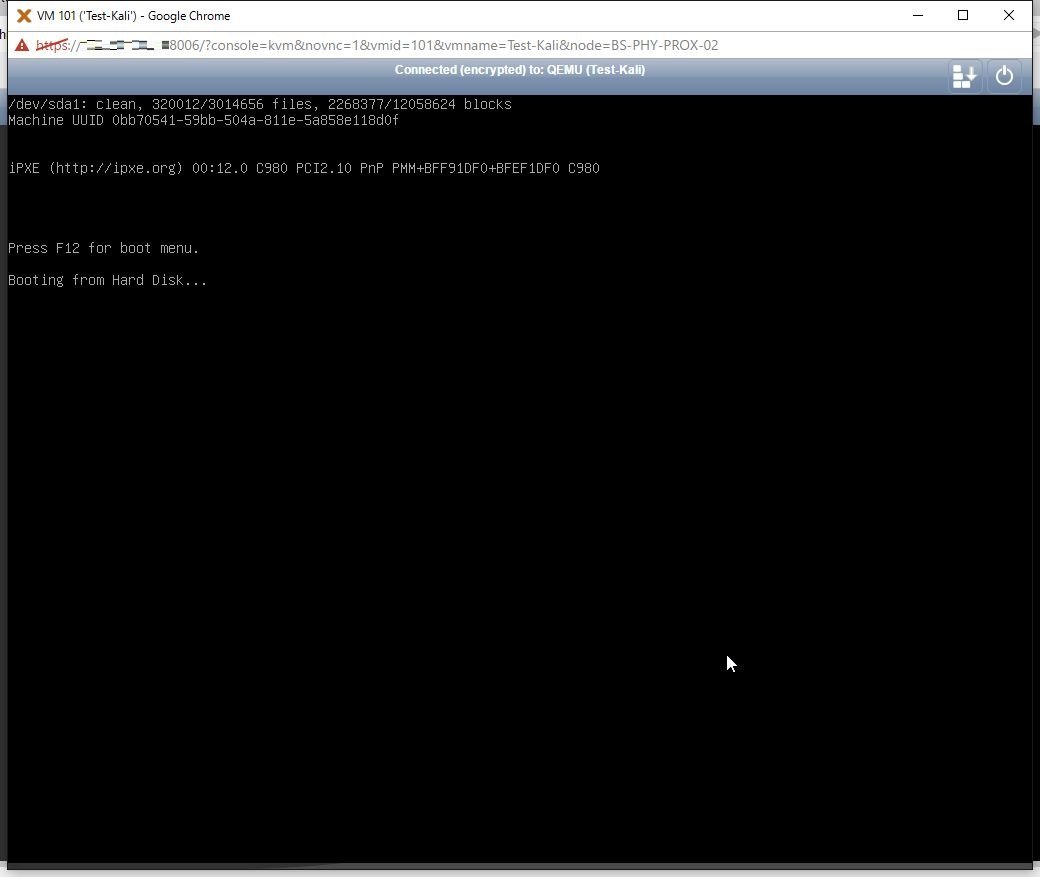

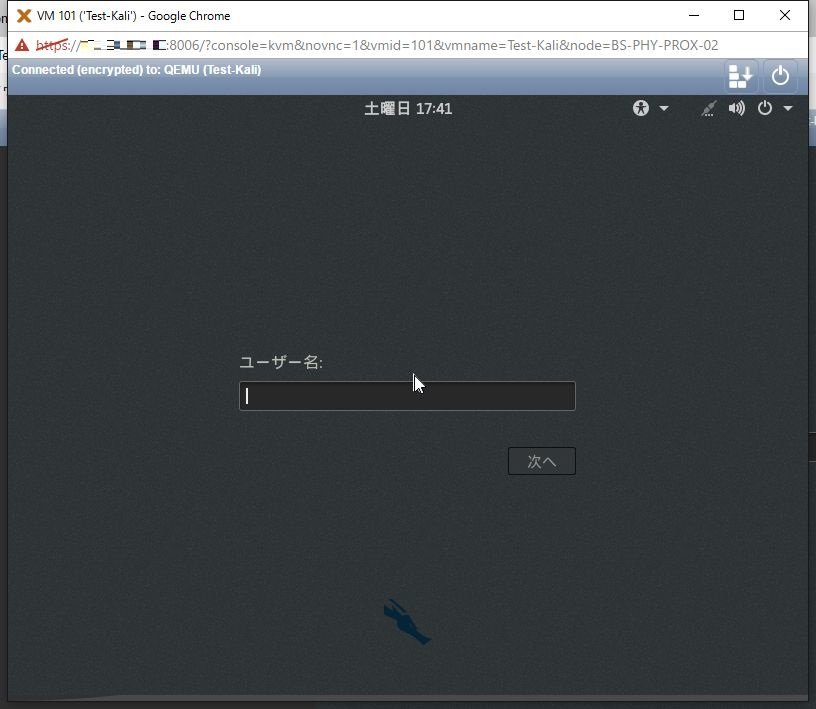

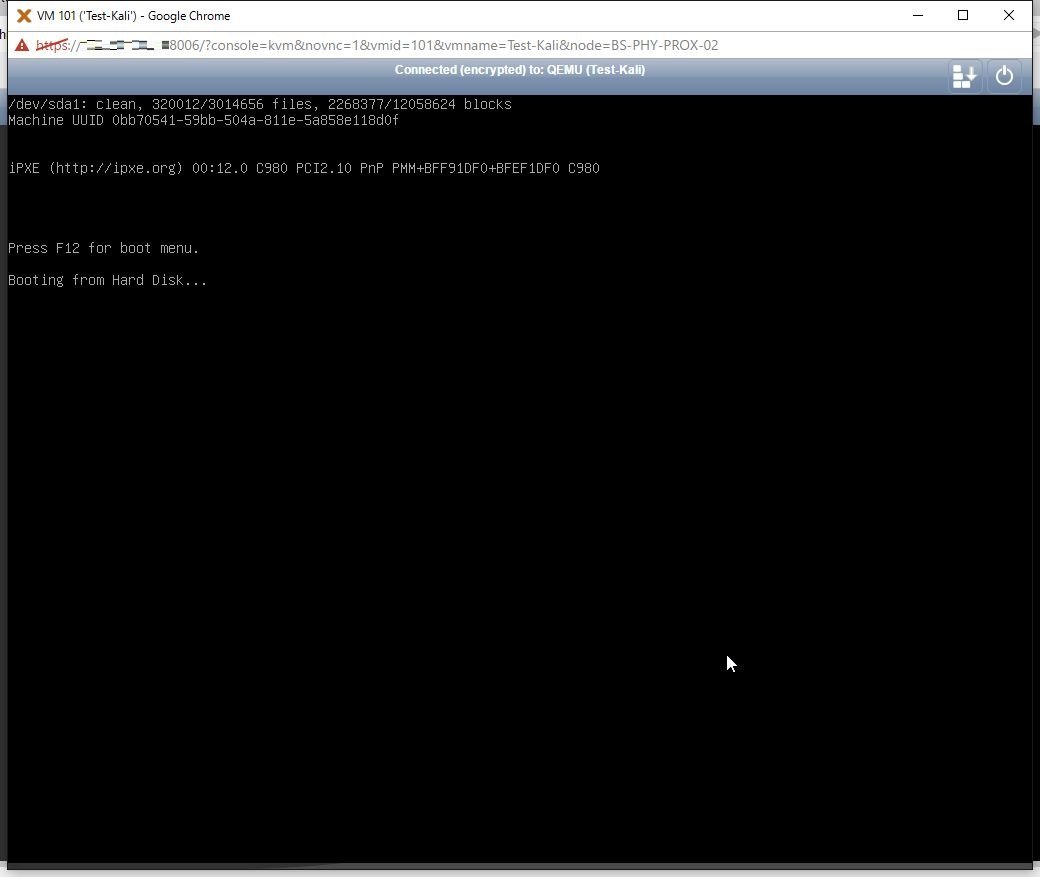

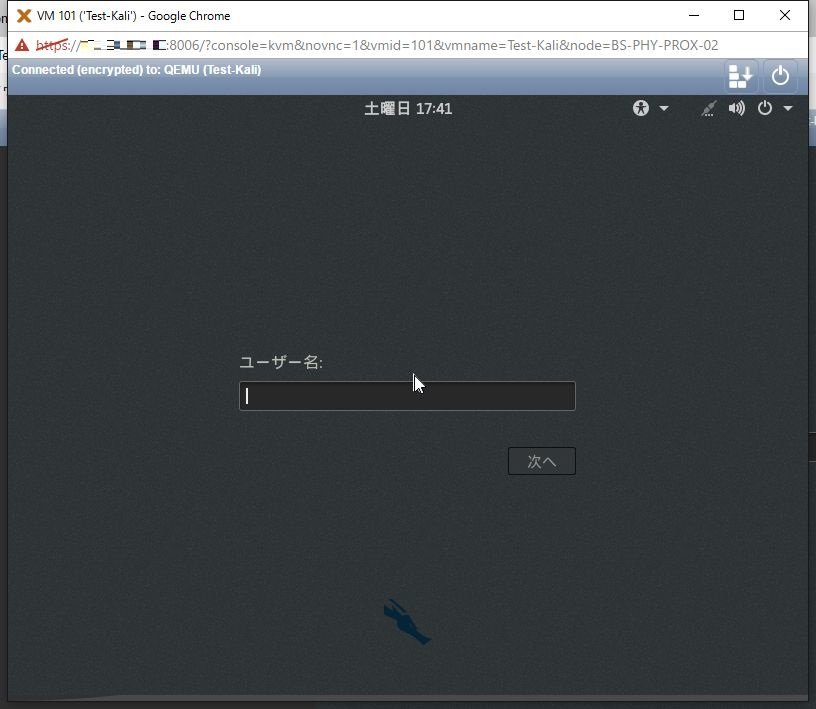

Proxmox VE 4.2上でKali Linux 2016.2を動作させる場合、普通にVMを作成すると、インストール後の最初のブート画面で以下のような画面で止まってしまい、その後先に進まないことがある。

これを回避するには、対象のVMを選択し[ハードウェア] > [ディスプレイ] で「VMware互換」を選択してやるとよい。

これで、無事ブートできるようになる。

参考

Proxmox VEでノード名を変更する場合、Linuxだからと言って「/etc/hostname」だけ変更するとうまくいかない。

ノード名の変更は、以下の手順で行う。

- 「/etc/hostname」を変更してやる

- 「/etc/hosts」を変更する

- 「/etc/postfix/main.cf」を変更する

上記設定変更後、以下のコマンドでpve-clusterを再起動する。

service pve-cluster restart

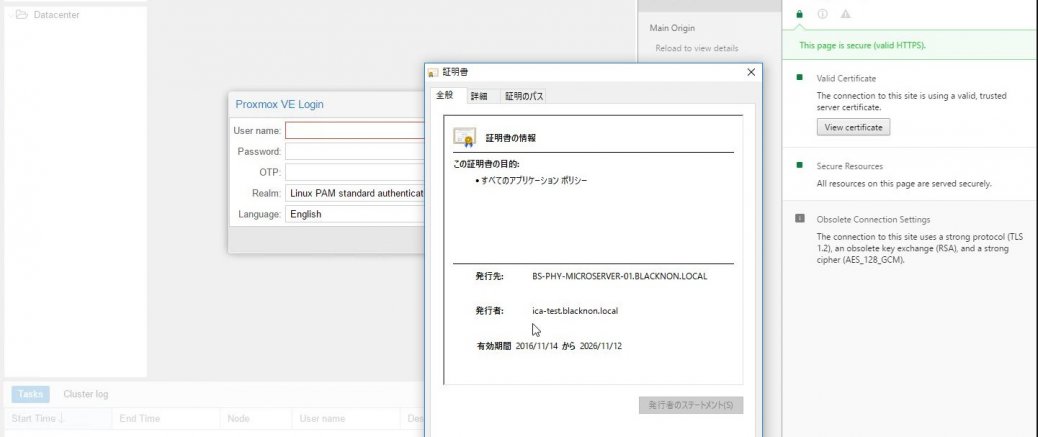

Proxmox VE4.2でSafariから仮想コンソールを開こうとすると、以下のようなエラーが出力される場合がある。

TASK ERROR: command '/bin/nc -l -p 5900 -w 10 -c '/usr/bin/ssh -T -o BatchMode=yes 192.168.0.112 /usr/sbin/qm vncproxy 123 2>/dev/null'' failed: exit code 255

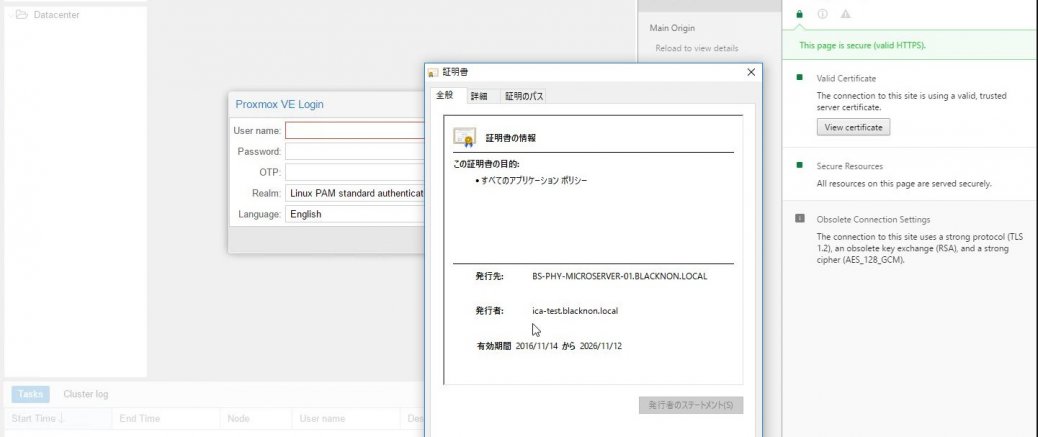

このエラーが出る原因だが、Proxmoxの証明書をデフォルトのまま(オレオレ証明書のまま)利用していると、信頼できないページということでSafari側...

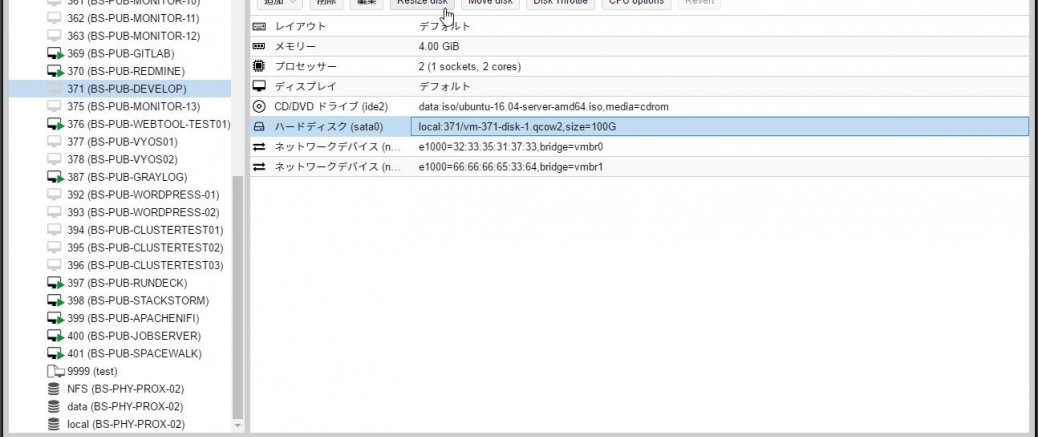

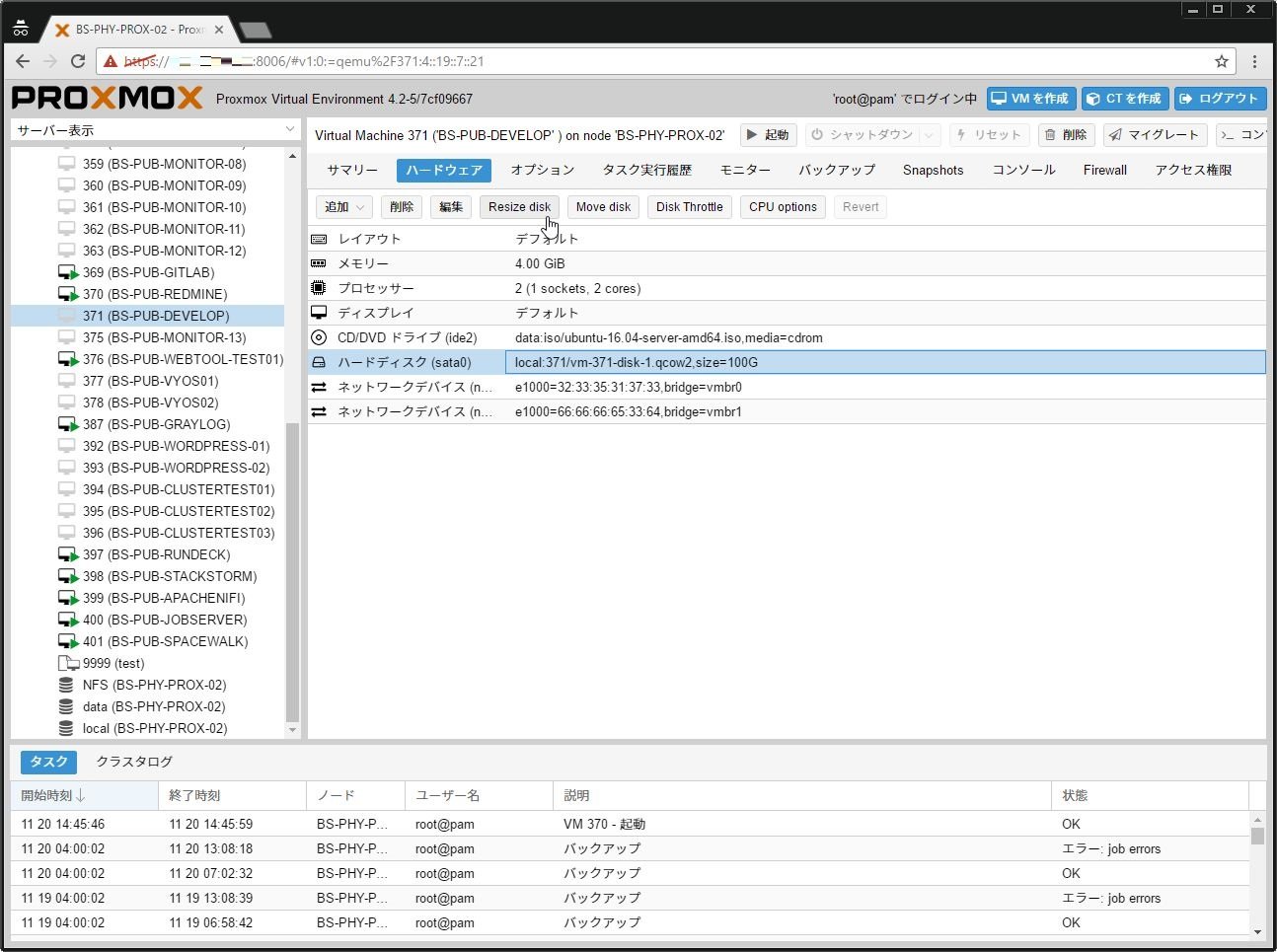

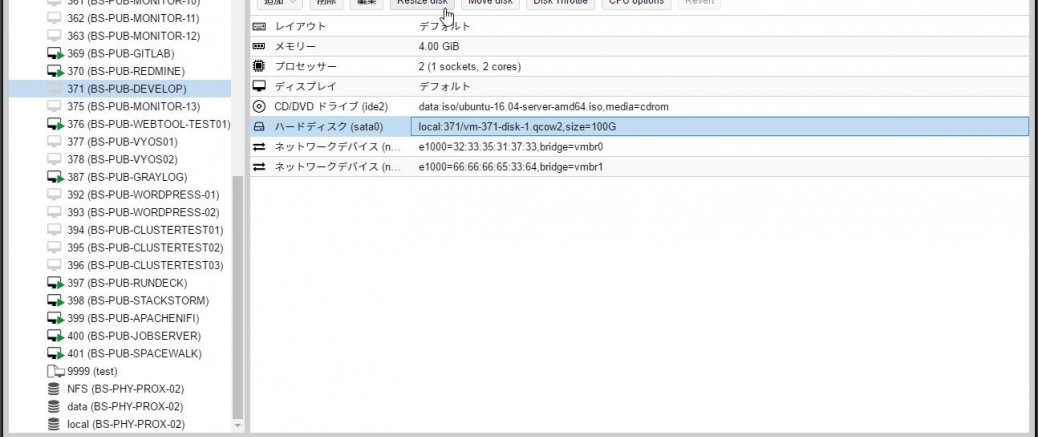

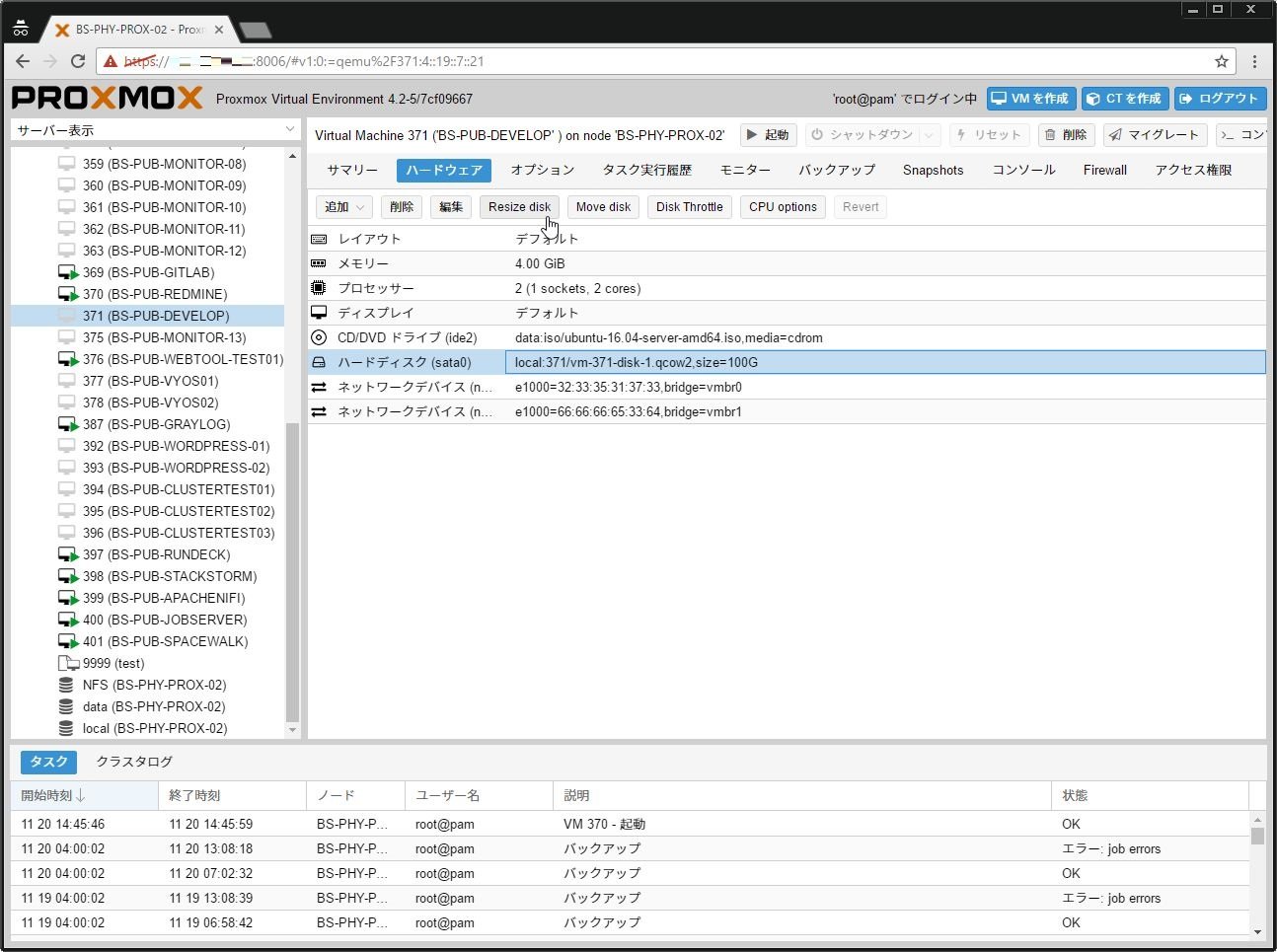

Proxmox VE 4.2でVMのディスクサイズを拡張する場合は、対象のVMを選択し[ハードウェア]タブを開き、拡張を行う仮想ハードディスクを選択して[Resize Disk]をクリックする。

Proxmox VEで、一度作成したVMのIDを後から変更する場合がある。

その場合、Web管理画面からは変更できないため、sshでログインしてコンソールから処理をする必要がある。

まず、VMが停止した状態で以下のように対象のVMの仮想HDDをリネームする。

mv /var/lib/vz/images/{移動元ID,移動後ID}

mv /var/lib/vz/images/移動後ID/vm-{移動前ID,移動後ID}-disk-1.qcow2

Proxmox VE では、サブスクリプションが無いとログイン時に『No Valid Subscription』という警告が表示される。

これを非表示にするには、以下のコマンドを実行して条件式を書き換えてやればよい。

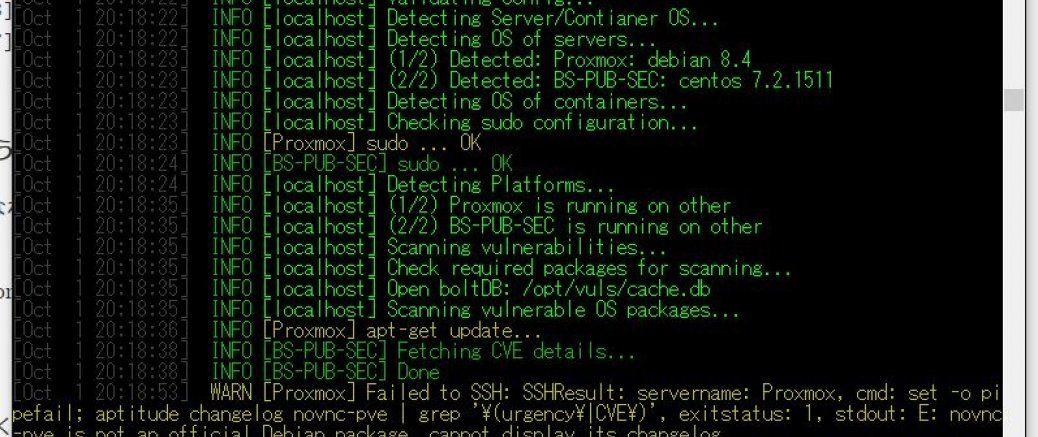

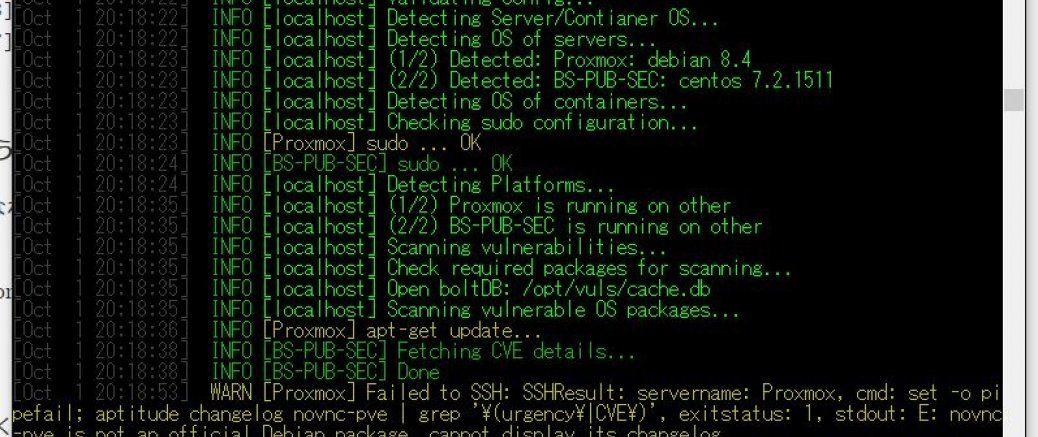

個人的に仮想基盤のソフトでDebianベースのProxmox VEと言うものを使っているのだが、Vulsでこれの脆弱性について検出できるかどうかやってみる事にする。

基本はDebianベースだからいけると思うのだけど…ちょっと微妙な結果になった。

1.ユーザ作成・鍵ファイルの設定

まず、Proxmox側にssh接続してvulsユーザの作成をする。

useradd vuls -b /opt -s /bin/bash

mkdir /opt/vuls

chown vuls. /opt/vuls

passwd vuls

次に、Vulsサーバからssh接続する際の鍵ファイルを登録、コン...

ProxmoxVE 4.2で監視をするためにZabbix Agentのインストールをする必要があったので、念のため手順を備忘として残しておく。

といっても、そもそもDebianなので手順としては簡単で、以下のようにコマンドを実行してAgentをインストール、あとは設定ファイルを編集するだけだ。

wget http://repo.zabbix.com/zabbix/3.0/debian/pool/main/z/zabbix-release/zabbix-release_3.0-1+jessie_all.deb

dpkg -i zabbix-release_3.0-1+jessie_all....

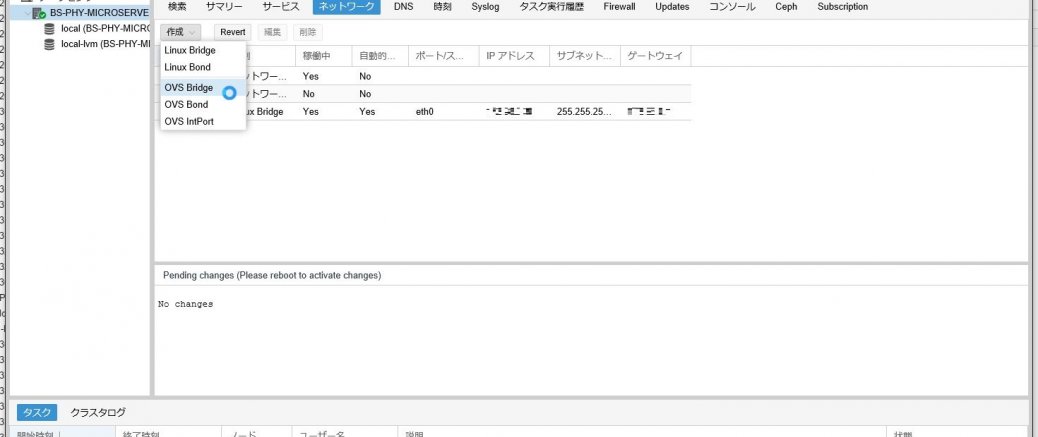

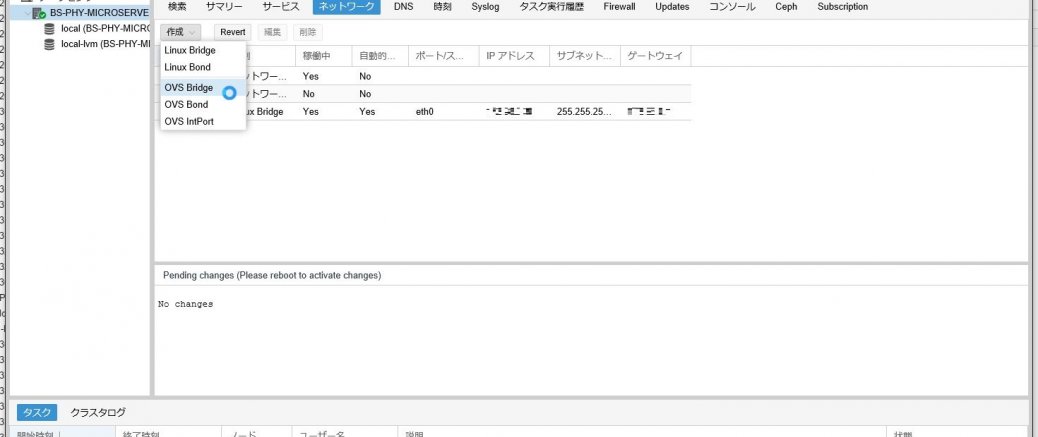

Proxmox VE 4.2で、接続するLANケーブル1本でトランクポートにして、Proxmox側でそれぞれのVMに応じてアンタグさせる必要があったので、OVS(Open vSwitch)を設定してVLAN設定をしてみた。

とりあえず、今回は検証なので以下のような構成で考えている(検証なので、裏の管理コンソールは別にLAN刺してる)。トランクポートに設定した以外のスイッチで各VLANのアンタグをさせて、そこにクライアント刺すことでテストをする。

- VLAN101 … 192.168.101.0/24

- VLAN102 … 192.168.102.0/24

- VLAN103 … 19...

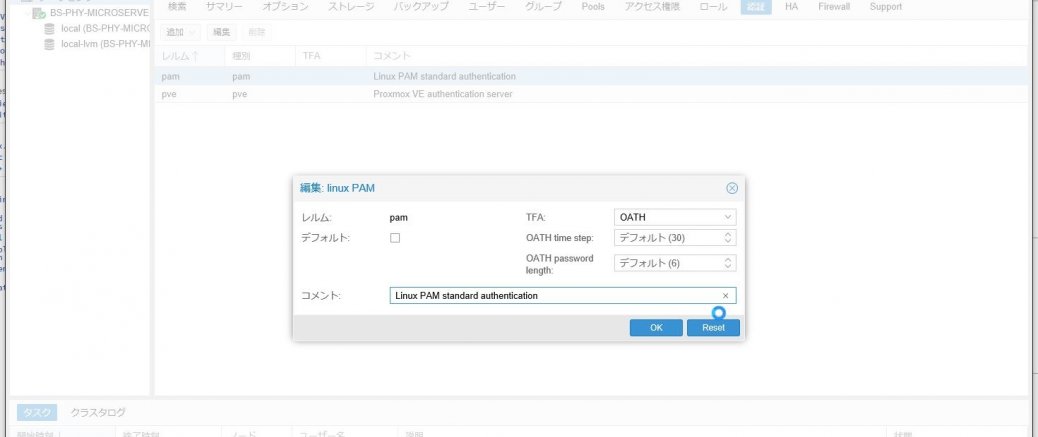

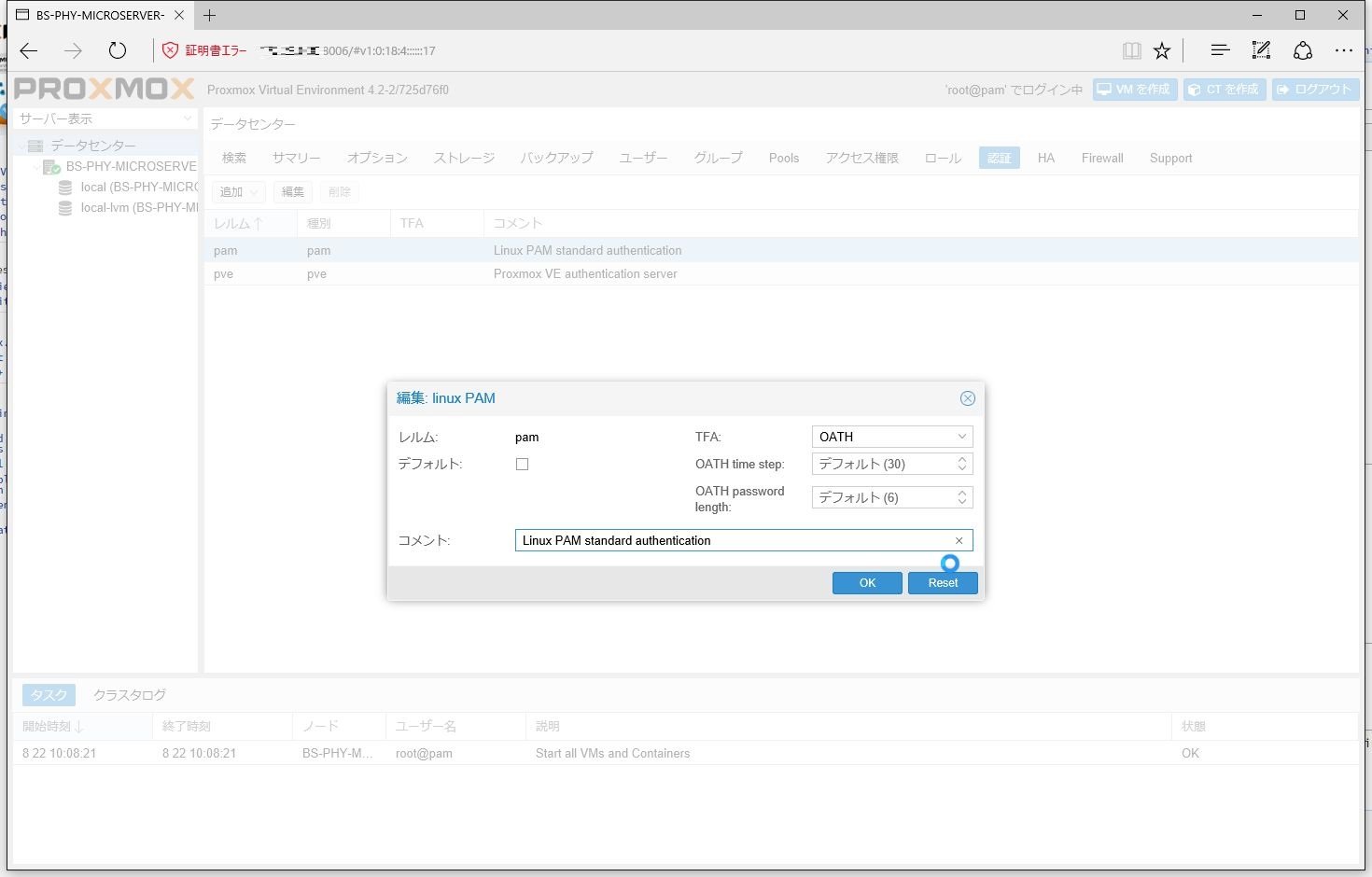

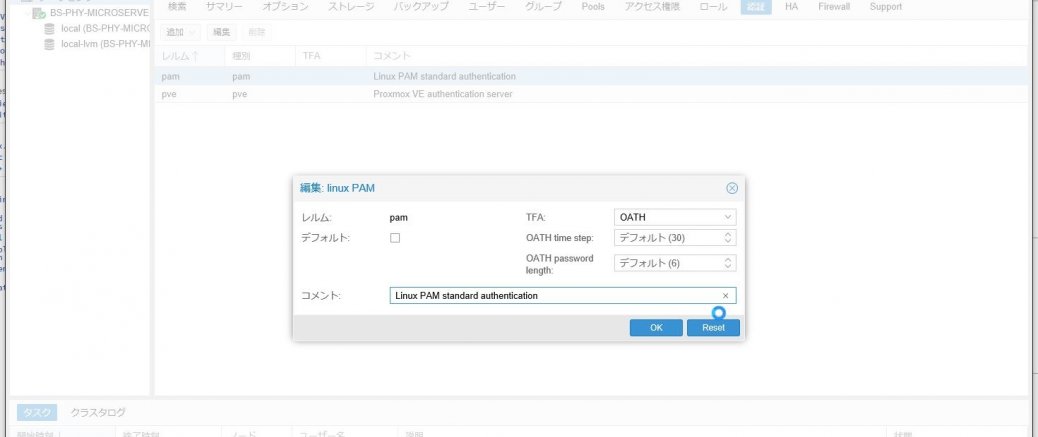

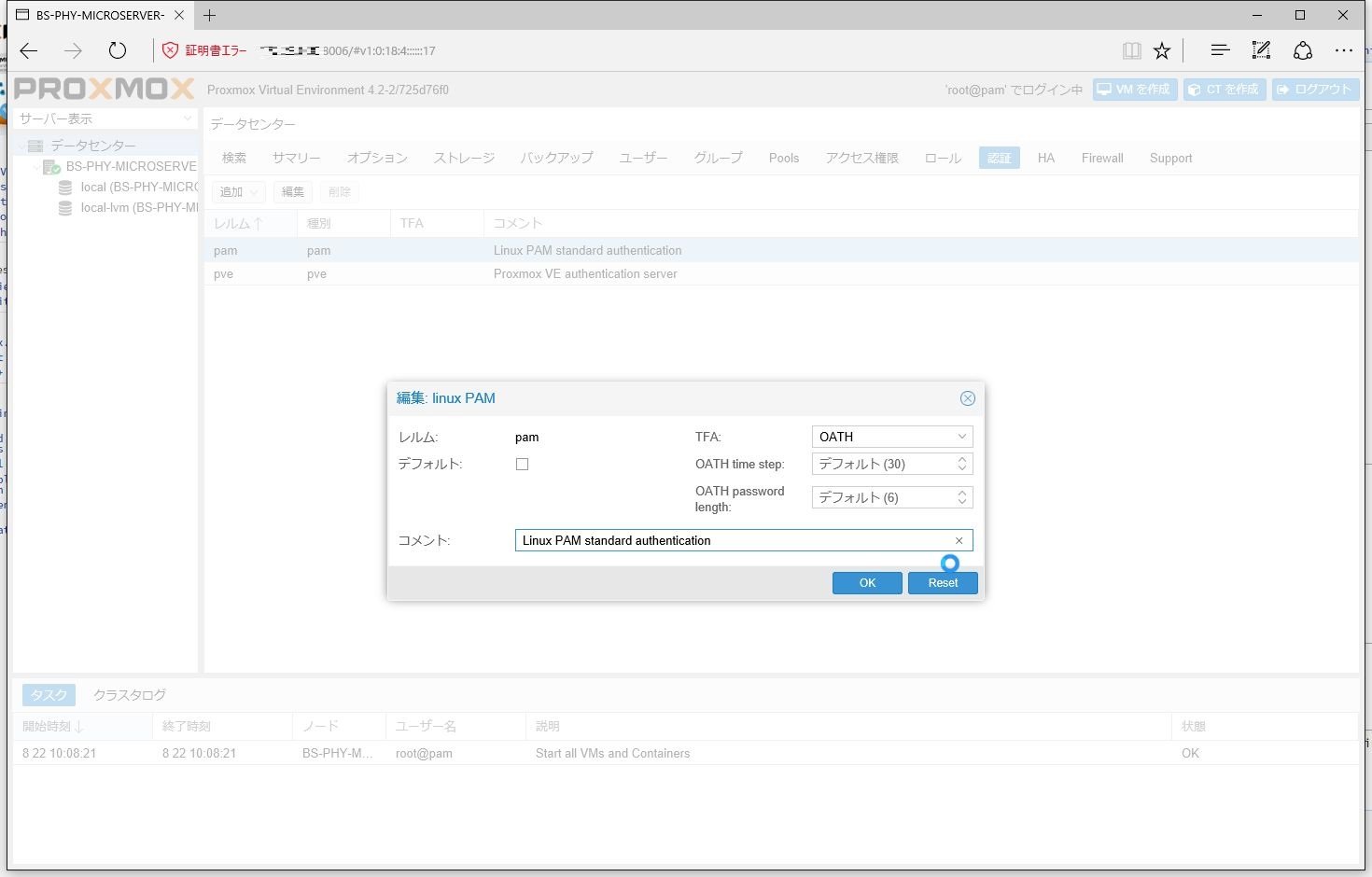

ここのとこワンタイムパスワードについていろいろ設定してるのだけど、どうやらProxmox VEでもOTPによる二要素認証が設定ができるようだ。

というわけで、試しに設定してみることにした。

設定方法は簡単。

[データセンター]から[認証]タブを選択し、ワンタイムパスワードを定義する認証方法(今回はpam)の設定画面を開く。

で、[TFA]の設定値を「OATH」と指定する。

次に、Proxmox VEのコンソール画面で以下のコマンドを実行し、ワンタイムパスワードのキーを生成する。

oathkeygen

root@BS-PHY-MICROSERVER-01:~# oa...

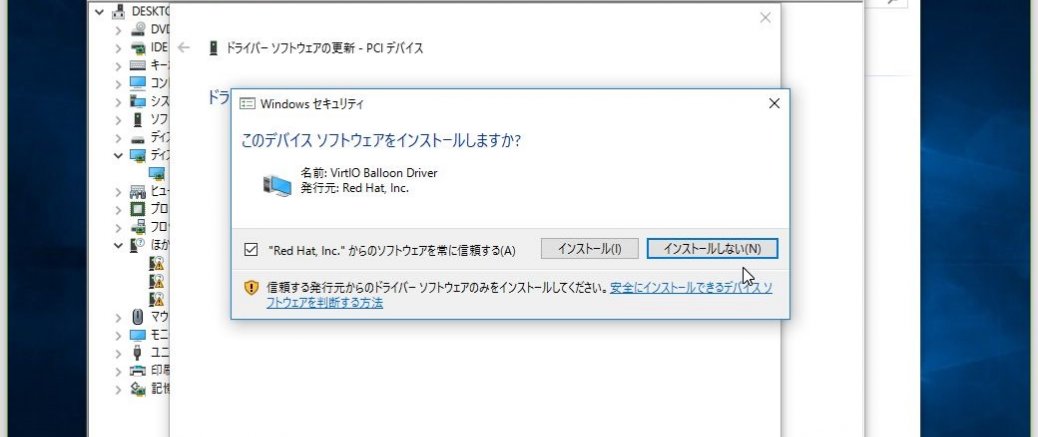

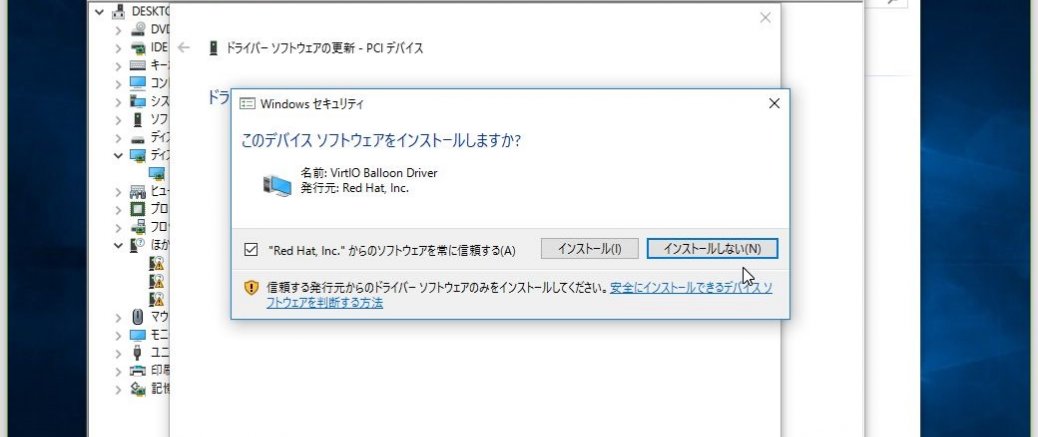

以前、Proxmox VE 3.1でWindows 7に対して行った処理だが、Proxmox VE 4.1上にWindows 10を入れたので同様の方法でVirtIO Driverを適用していく。

VirtIO Driverは、乱暴な言い方をしてしまえばKVM用のVMware Toolsのようなもので、仮想マシンにインストールすることでパフォーマンスを改善したりすることができるものだ。

まずはISOファイルのダウンロード。

以下からダウンロードしてくる。

ダウンロードしてきたISOファイルを、対象の仮想マシンが読み込めるス...

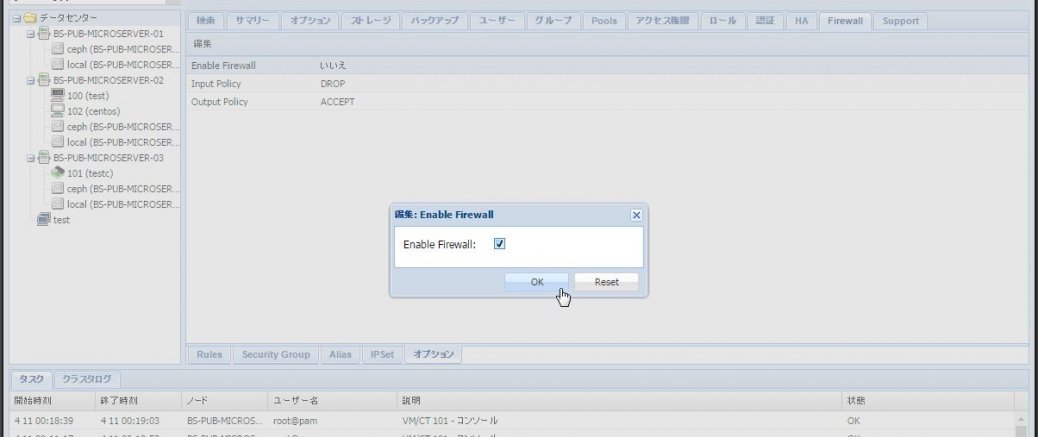

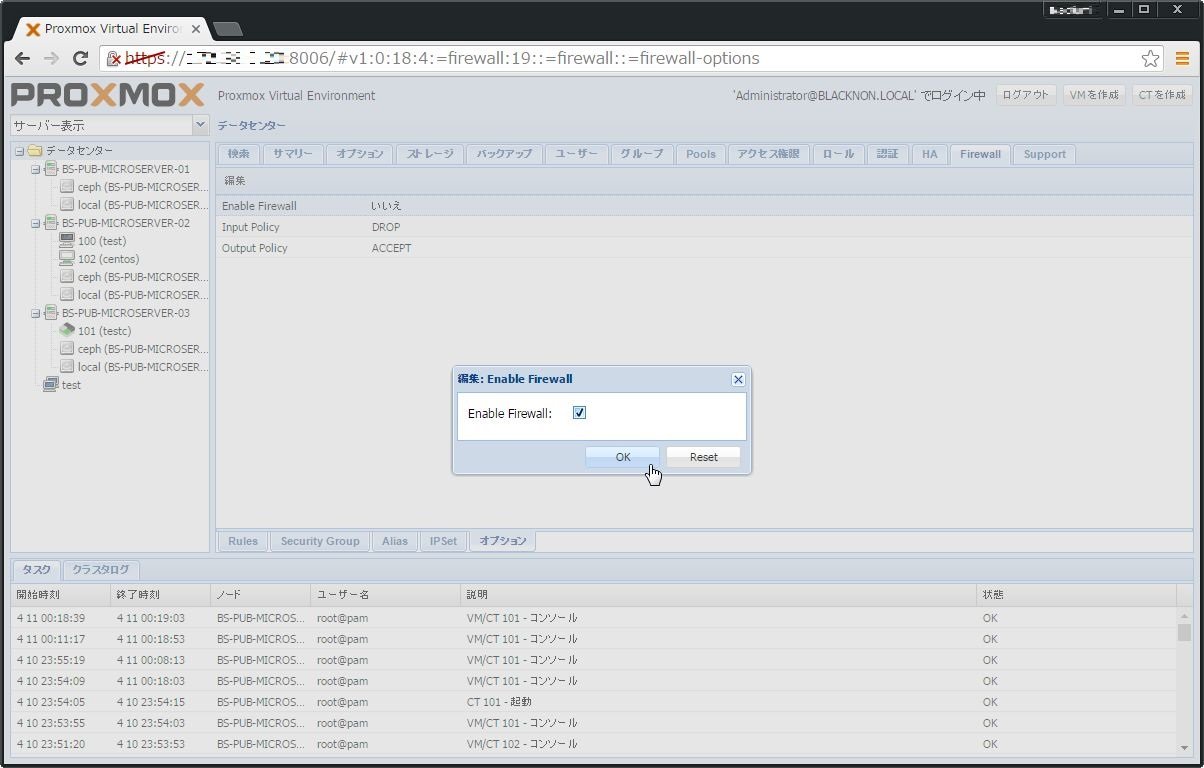

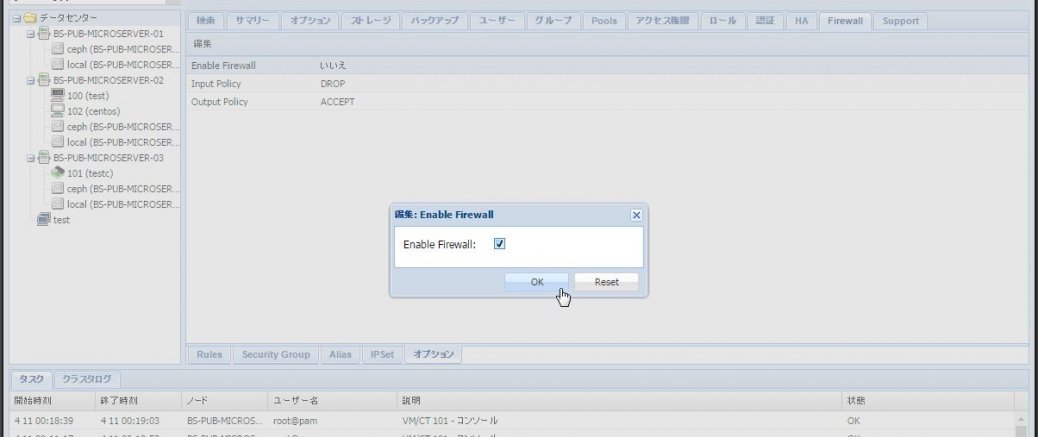

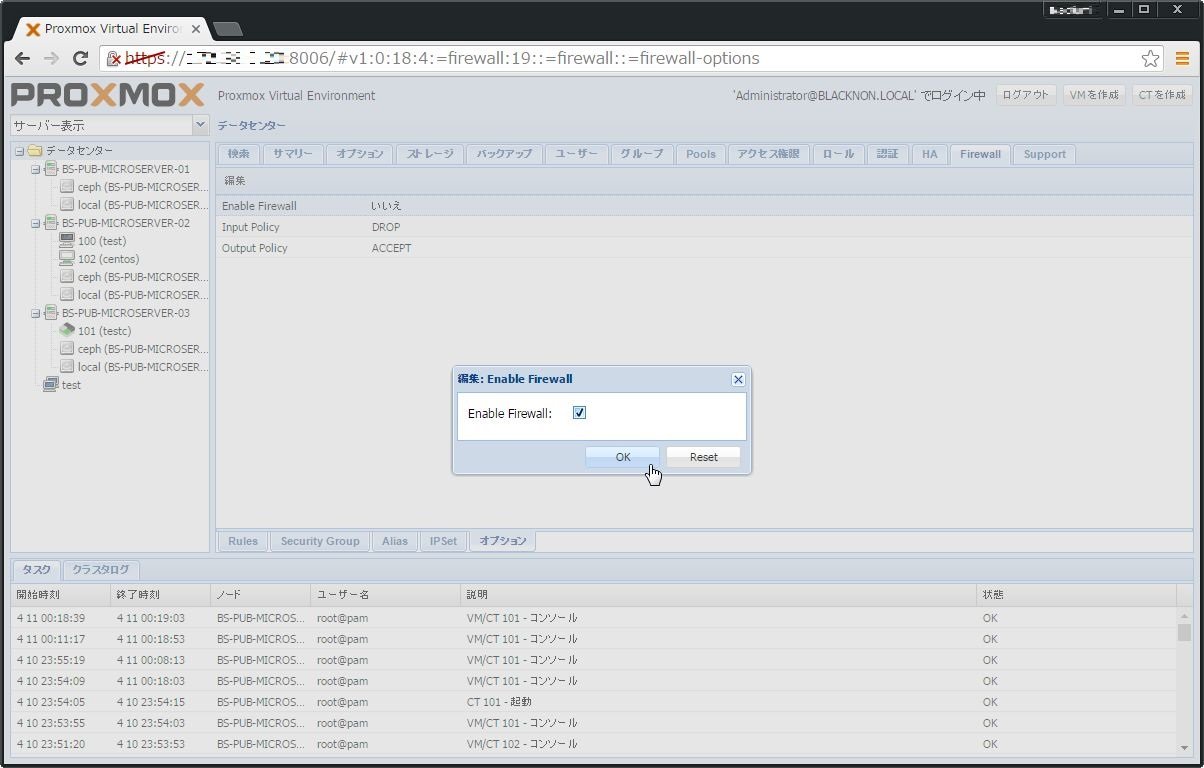

Proxmox VEでは、動作しているVMへのアクセスに対し、Proxmox側でファイアウォールの管理ができるようになっている。

今回は、このファイアウォール機能を実際に動作させてみる。

Proxmoxのファイアウォール機能は、データセンターで管理する。

まず、データセンターを選択し[Firewall] > [オプション] で、[Enable Firewall] を「はい」に切り替える(チェックを入れる)。

次に、ファイアウォールを動作させたいVMを選択し、[Firewall] > [オプション] で、[Enable Firewall] を「はい」に切り替える(チェックを入れる...

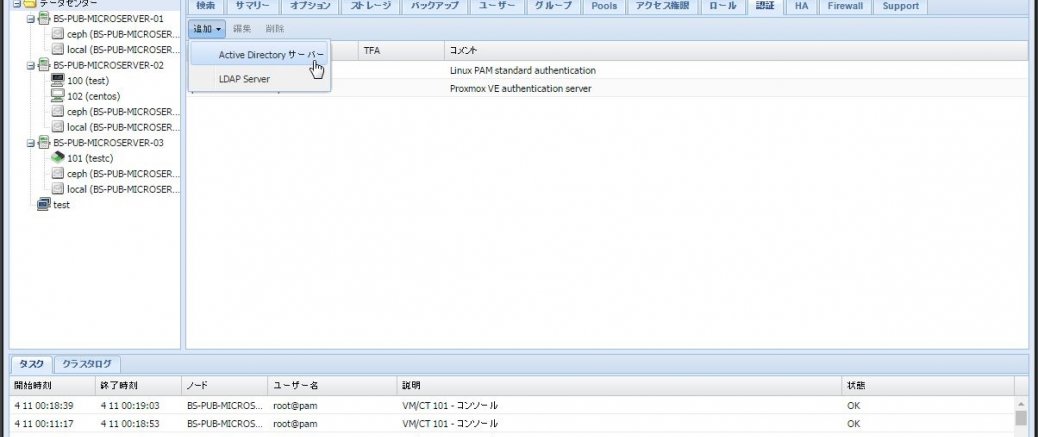

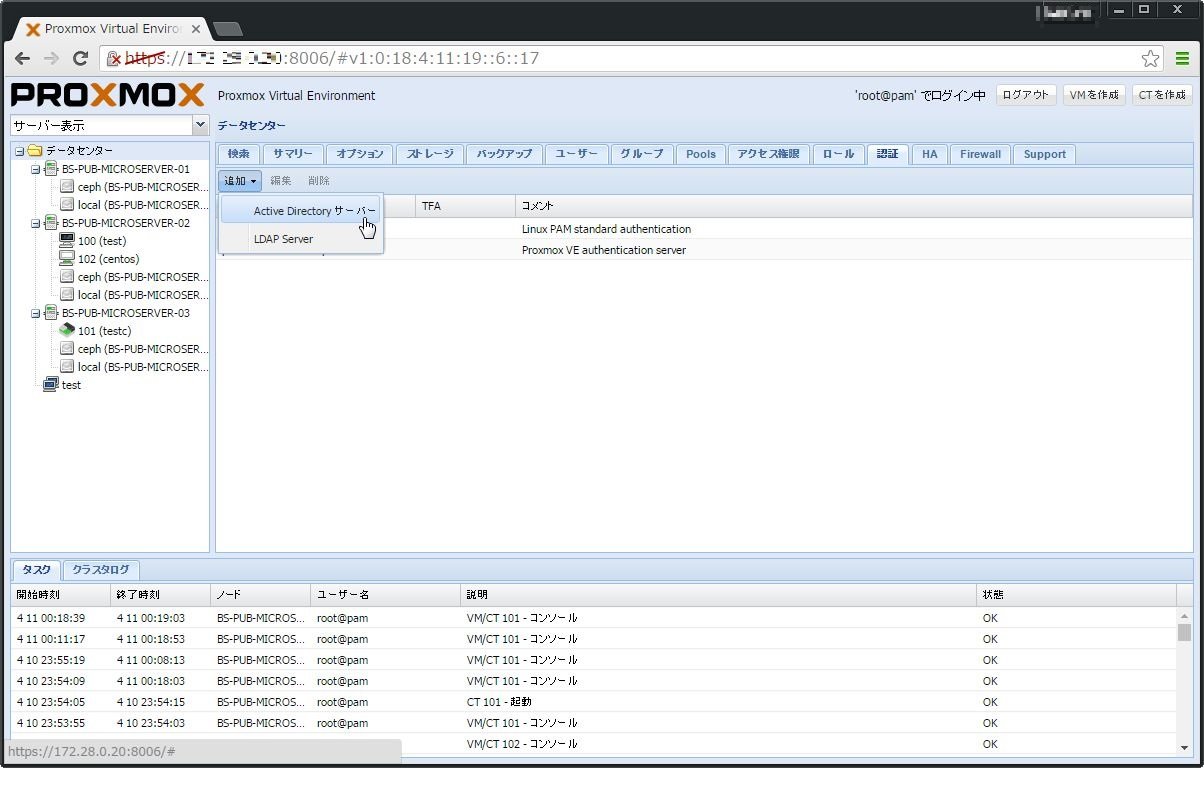

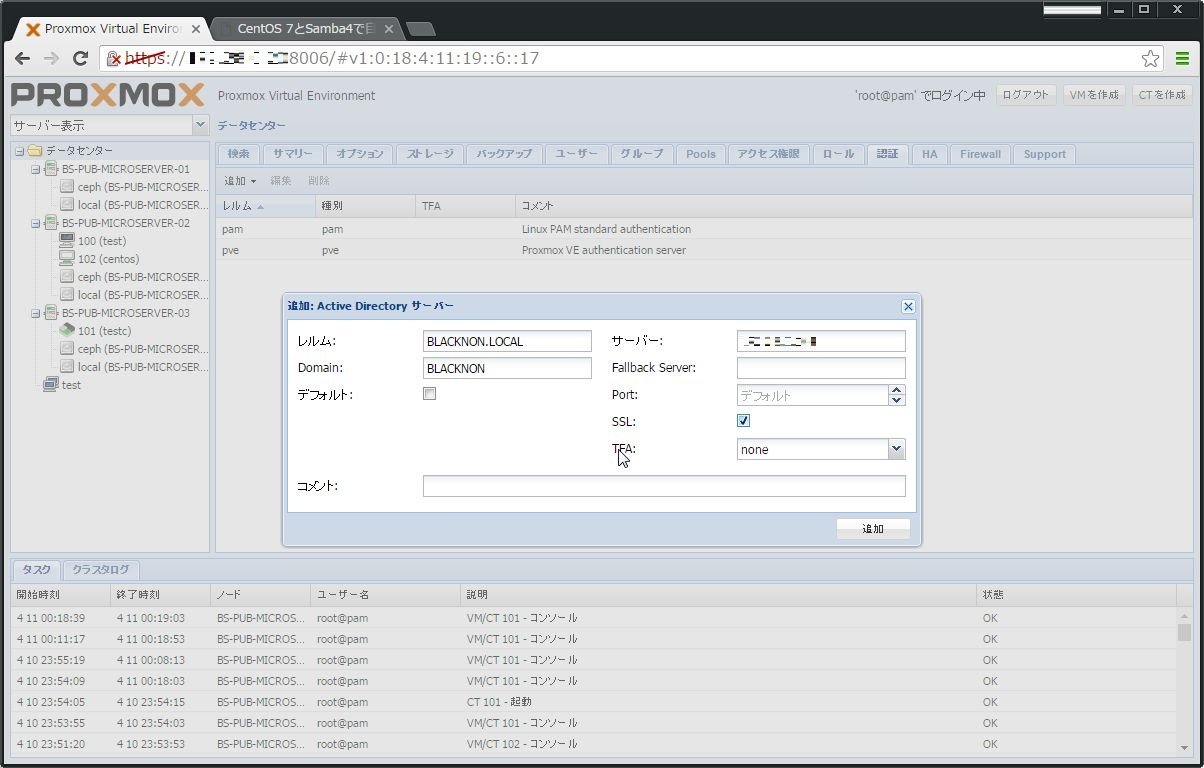

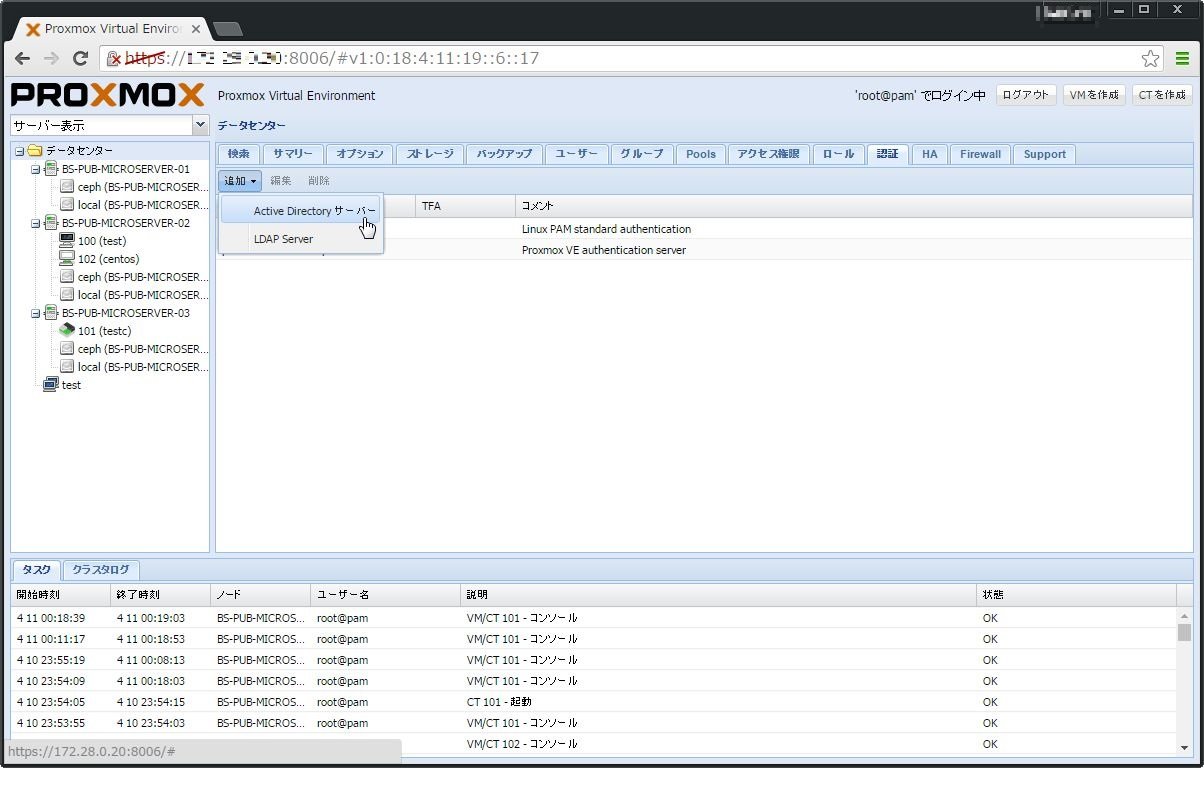

Proxmox VE 4.1ではWebGUIから設定してActive Directory連携を行わせる事が出来る。

今回は、CentOS 7 + Samba4で作成したDomain ContollerとProxmox VE 4.1でこの連携を行う。

連携設定は簡単。

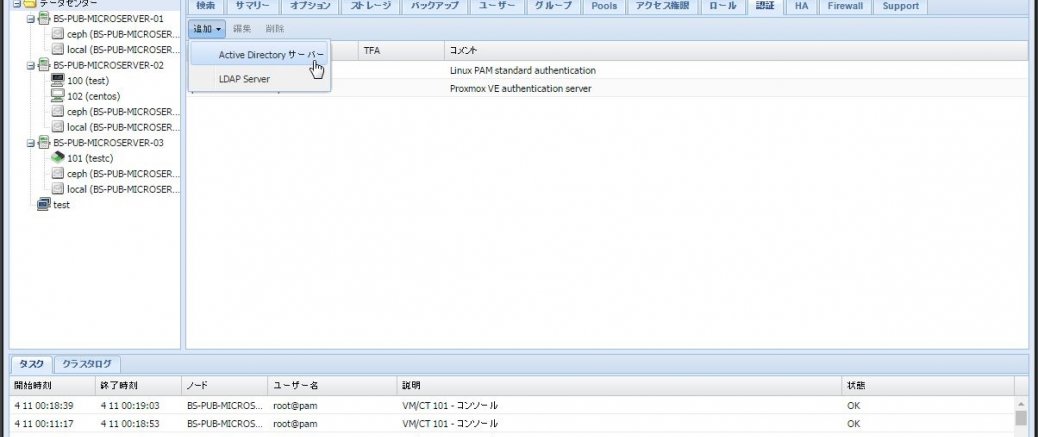

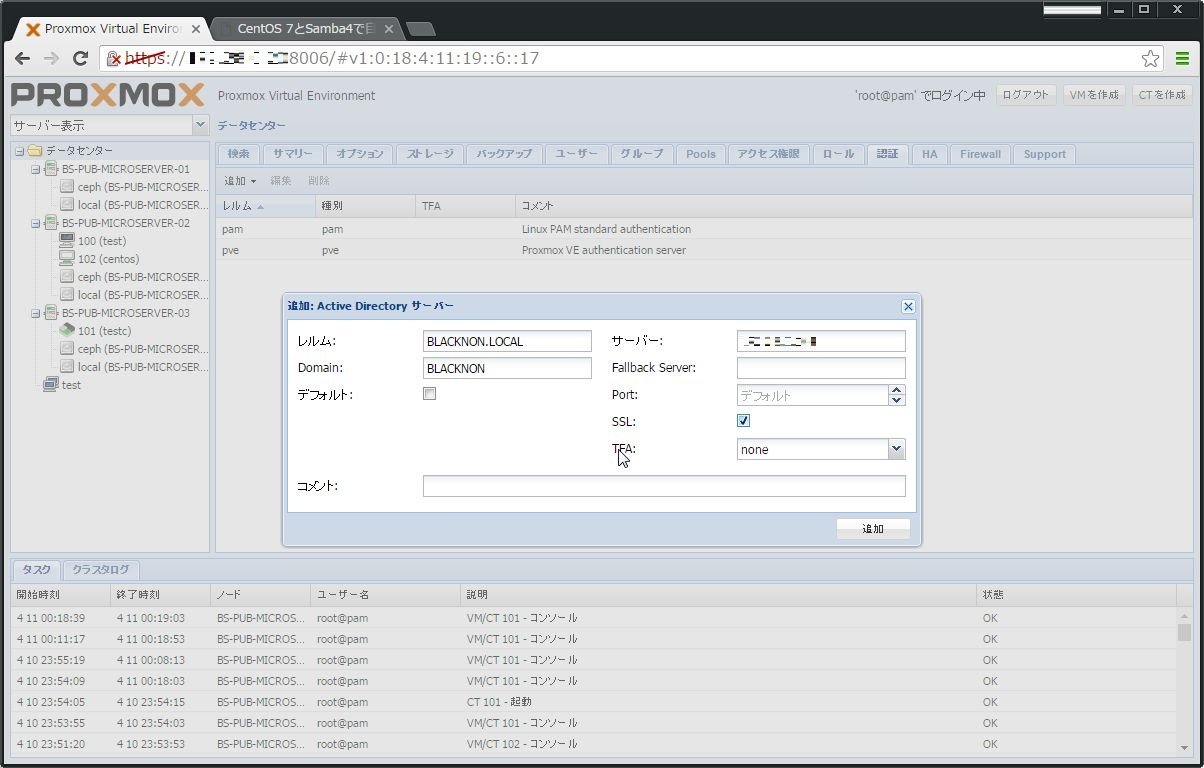

まず、[データセンター] > [認証] > [追加]で、Active Directoryを選択する。

レルムやドメイン、DCサーバの情報などの環境情報を入力する。

で、ここまでで終わるのかな?と思ってたのだが、どうやらグループやその権限、グループに所属するユーザとしてADのユーザも作らないといけないらしい。...

以前にVMWare ESXiで似たような設定をしていたが、Proxmox VEでも出来ないか調べてみた。

まぁ、流石に基本KVM(& OpenVZ)なので、問題なく設定できるようだ。

1.シリアルコンソールの追加

VMへシリアルコンソールを追加するのは簡単で、Proxmox VE 4.1のホストで、以下のコマンドを実行するだけだ。

qm set -serial0 socket

root@BS-PUB-MICROSERVER-02:~# qm set 102 -serial0 socket

update VM 102: -serial0 socket

VM...

Proxmox VE 4.1では、クラスタを構成する各ノードにオブジェクトストレージである「Ceph」をインストールし、OSDとして動作させることが出来る。

つまり、Proxmoxのクラスタノードが10台以上とかいても、共通アクセスするストレージ機器を用意することなく動作を継続することが出来るということになる。イメージ的には、vSANに似たように利用することが可能となる。

Cephそのものの動作については、以下のページを参考にするとよいだろう。

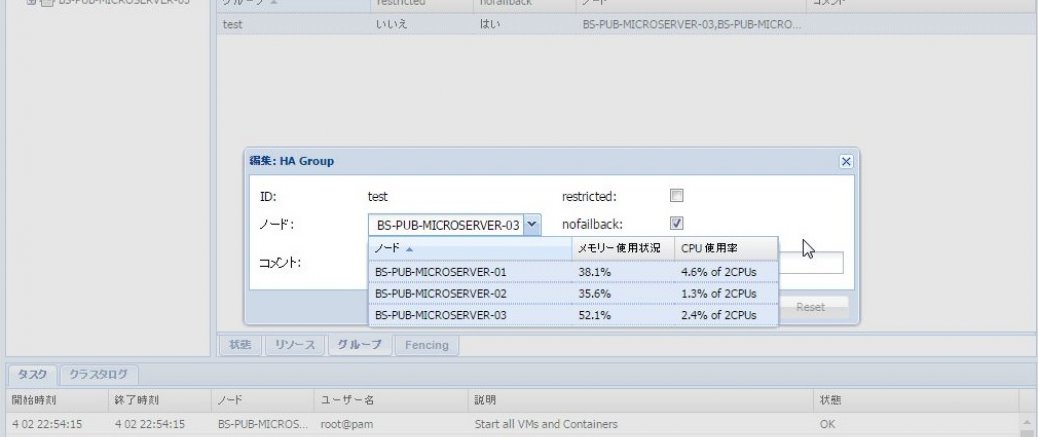

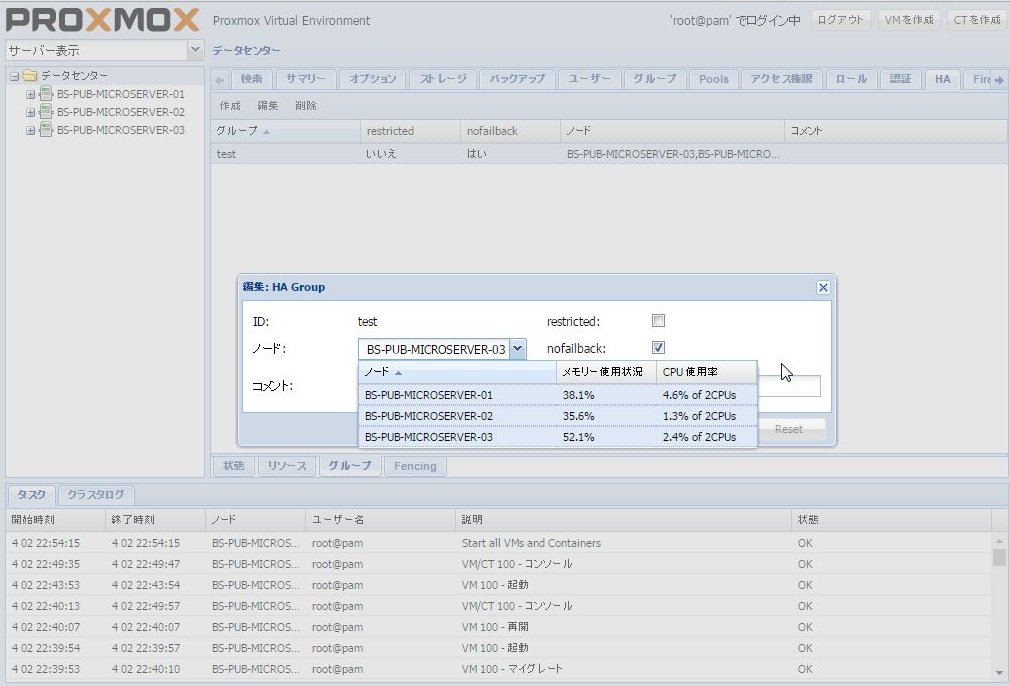

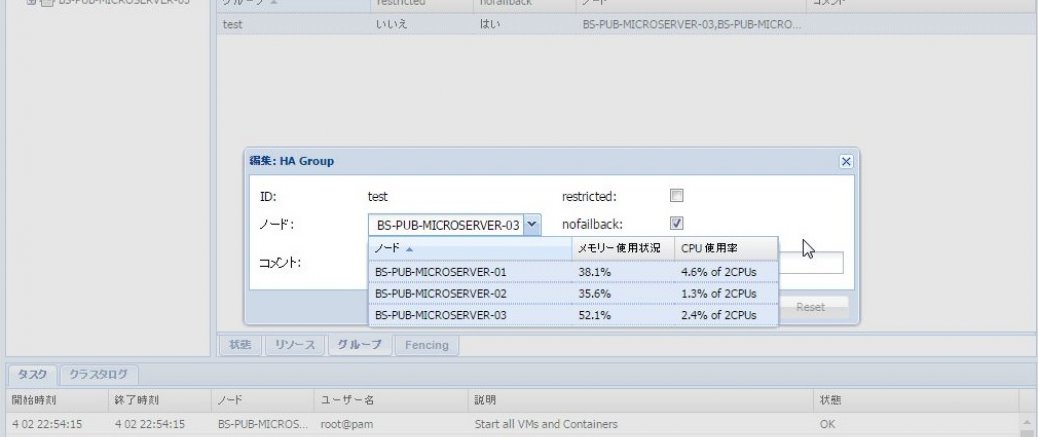

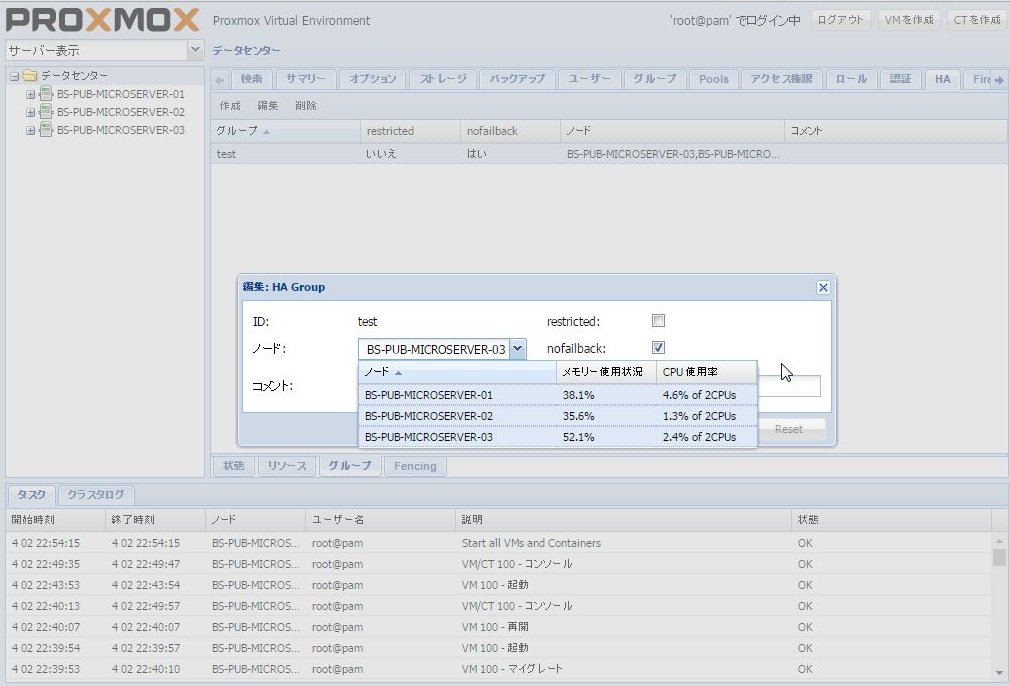

前回、Proxmox VE 4.1でDRBD9の設定を行い、ライブマイグレーションが行えるようにしたので、今回はHA化の設定を行う。

この設定を行う事で、物理ノードに何かが合った場合、VMが自動的に別ノードにマイグレーションされて再起動されるようになる。

ただし、注意したいのがノードが最小で3台以上であること。

2台構成では動作しないので注意だ。

まず、WEBコンソールから[データセンター] > [HA] > [グループ]を開き、[作成]からHAグループを作成する(ここでは、グループIDを「test」としている)。

Proxmox VEでは、簡単にクラスタにノードを追加することができる。

追加したいノードで以下のコマンドを実行することで、クラスタへの参加が行える。

pvecm add クラスタIPアドレス

Proxmoxのクラスタ間でのライブマイグレーションを行う場合、通常であればiSCSIやSANで仮想HDDなどをおいておくストレージが必要なのだけど、それなしでもvSANやNutanix CEを利用するようにしてライブマイグレーションを出来ないか調べてみた。

一応、ProxmoxのノードでCeph(RBD)を利用することが出来るのだけど、そうなると最低でも3台構成以上じゃないとあまり旨味が無いので、なんかいい方法が無いかと調べていたところ、各クラスタノードで共通のディレクトリ(ディスク)をDRBDで同期させて、そこに仮想マシンのファイルを配置することで対応出来そうだったので、やってみることに...

Proxmox VE 4.1でHyperVのディスクイメージを利用する場合、KVMで利用できるような形式に変換する必要がある。

1.仮想マシンの作成

まず、こちらを参考にKVMのディスクイメージを利用する仮想マシンを作成する。

作成時、今回の場合はディスクイメージタイプはraw、ディスクイメージは出来れば後ほどアップロードするimgファイルと同じ容量で作成を進める。

※ディスクイメージタイプ・容量が違う場合、仮想マシンの設定ファイル(/etc/pve/nodes/仮想ホスト名/qemu-server/仮想マシンID.conf)を直接いじって、ディスク容量をいじってやらないといけ...

Proxmox VE 4.1では、KVMベースではあるが、残念ながらWebコンソールから他の仮想プラットフォームからのイメージをインポートする方法が無い(KVMのディスクイメージ含む)。

そのため、ターミナルからの操作が必要となってくる。

今回は、KVMのディスクイメージ(.img)ファイルをインポートして、Proxmox上で利用する方法について記述する。

1.仮想マシンの作成

まず、こちらを参考にKVMのディスクイメージを利用する仮想マシンを作成する。

作成時、ディスクイメージタイプはraw、ディスクイメージは出来れば後ほどアップロードするimgファイルと同じ容量で作成を進める。

※ディスクイメージタイプ・容量が違う場合、仮想マシンの設定ファイル(/etc/pve/nodes/仮想ホスト名/qemu-server/仮想マシンID.conf)を直接いじって、ディスク容量をいじってやらないといけない。

Proxmox VE 4.1では、ターミナルでの操作は必要となってくるが、以下のように操作することでVMware ESXiのディスクイメージ(vmdkファイル)をそのまま利用出来る(Webコンソール上からインポート出来ないけど)。

1.仮想マシンの作成

まず、こちらを参考にVMeare ESXiのディスクイメージを利用する仮想マシンを作成する。

作成時、ディスクイメージタイプはraw、ディスクイメージは出来れば後ほどアップロードするimgファイルと同じ容量で作成を進める。

※ディスクイメージタイプ・容量が違う場合、仮想マシンの設定ファイル(/etc/pve/nodes/仮想ホスト名/qemu-server/仮想マシンID.conf)を直接いじって、ディスク容量をいじってやらないといけない。

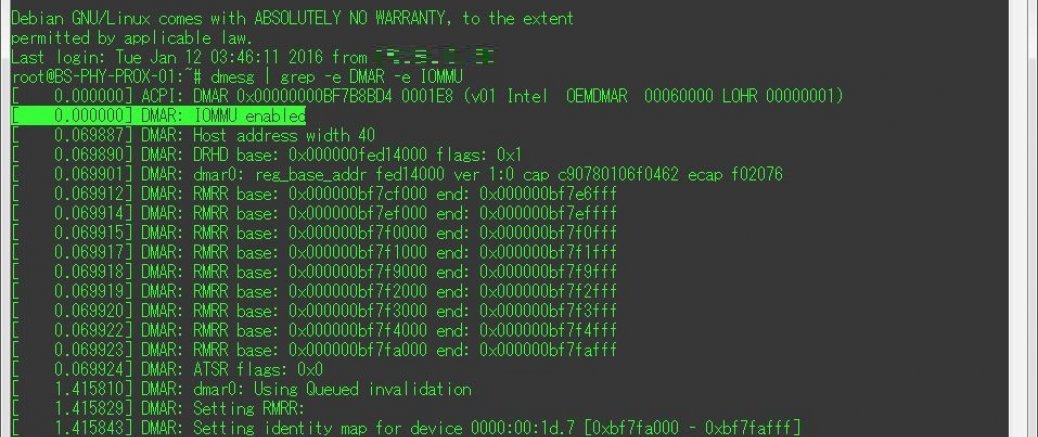

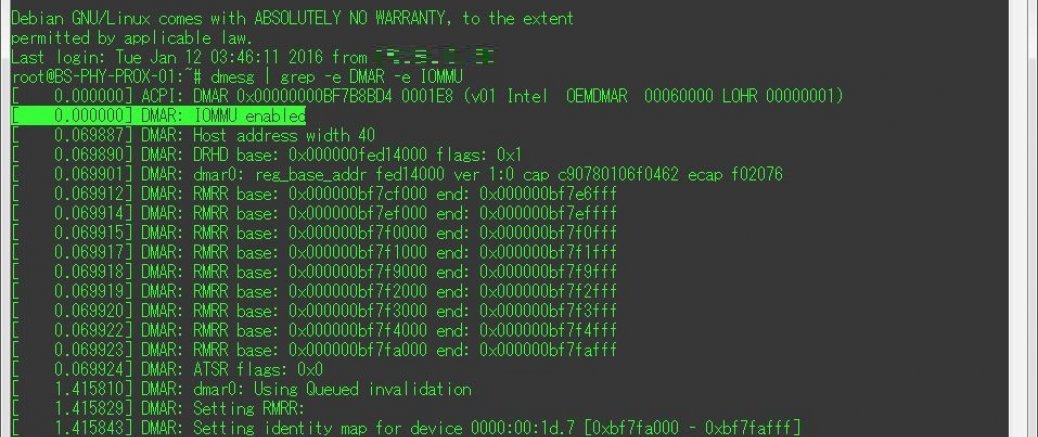

以前、Proxmox VE 3.1でPCIパススルーを行っているが、それと同様の処理をProxmox VE 4でも行ってみる。

前回と同じく、まずは以下のコマンドでgrubを編集し、Intel VT-dを有効にする。

sed -i '/GRUB_CMDLINE_LINUX_DEFAULT/cGRUB_CMDLINE_LINUX_DEFAULT="quiet iommu=pt intel_iommu=on vfio_iommu_type1.allow_unsafe_interrupts=1"' /etc/default/grub

update-grub

再起動後、以下のコマンドでI...

この度、ラックを買ったので自宅環境を一新するにあたり、仮想基盤を全てProxmoxで統一(一部テスト用にESXi)したのだけど、その際に仮想マシンにUSBパススルー設定をする必要があったのでその備忘。

WebUIから設定が行えないので、基本的にCUIで設定を行う必要がある。

まず、ProxmoxVEホストにssh接続し、lsusbでパススルーしたいUSBのBUSを確認する。

lsusb

root@BS-PHY-PROX-01:~# lsusb

Bus 002 Device 002: ID 0bda:817f Realtek Semiconductor Corp. RTL8188R...